NVIDIA NIM 透過高效的推論微服務,幫助您充分利用已訓練好的 AI 模型,將其快速轉化為實際應用,創造商業價值。

什麼是 NVIDIA 藍圖?

NVIDIA Blueprints 是針對代理和生成式 AI 使用案例的參考工作流程。企業可以使用 Blueprints 以及 NVIDIA AI 和 Omniverse 函式庫、SDK 和微服務,來構建和運營自定義的 AI 應用程式——創建數據驅動的 AI 飛輪。Blueprints 還包括合作夥伴的微服務、參考代碼、自定義文檔和用於大規模部署的 Helm 圖表。借助 NVIDIA Blueprints,開發人員可以受益於跨 NVIDIA 堆棧的統一體驗——從雲端和數據中心到 NVIDIA RTX™ AI PC 和工作站。

NVIDIA NIM 是一套易於使用的推理微服務,專為加速在任何雲端、數據中心、RTX AI PC和工作站上部署生成式AI模型而設計。

主要特點

高性能功能包括:

- 可擴展部署:能從少數用戶無縫擴展至數百萬用戶

- 先進語言模型支援:為各種尖端LLM架構提供預先優化的引擎

- 靈活整合:提供與OpenAI API相容的程式模型

- 企業級安全性:使用safetensors確保安全

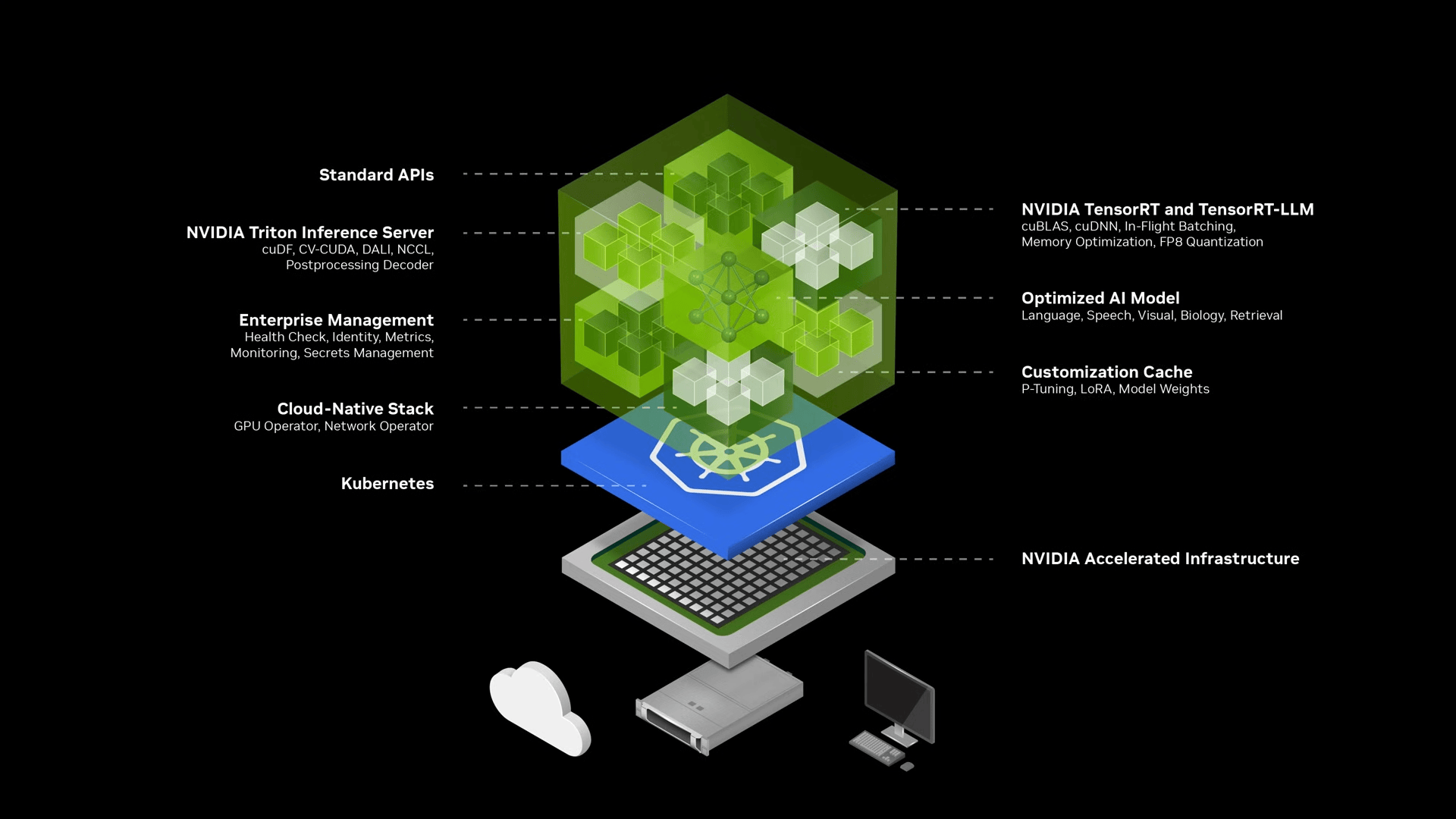

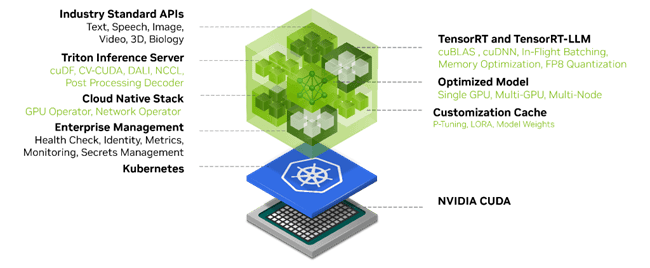

技術架構

- NIM以容器映像方式打包,每個模型/模型系列都有專屬容器

- 自動下載模型並選擇最佳硬體版本

- 使用TRT-LLM或vLLM庫進行推理

- 透過NVIDIA NGC Catalog分發

應用範圍

NIM支援多種AI應用場景:

- 聊天機器人和虛擬助理

- 內容生成和摘要

- 情感分析

- 語言翻譯

最新發展

NVIDIA最近宣布了支援RTX AI PC的NIM微服務:

- 支援新的GeForce RTX 50系列GPU

- 提供高達3,352萬億次AI運算性能

- 具備32GB VRAM

- 支援FP4計算,使AI推理性能提升2倍

開發者優勢

- 簡化從實驗到部署AI應用的過程

- 提供預優化模型和行業標準API

- 支援建立AI代理、副駕駛、聊天機器人和助手

- 可在NVIDIA GPU上實現從雲端到PC的無縫AI推理

Nvidia NIM

NVIDIA NIM,作為NVIDIA AI Enterprise的一部分,為開發 AI 驅動的企業應用程式和在生產環境中部署 AI 模型提供了一條簡化的路徑。

NIM 是一套優化的雲原生微服務,旨在縮短上市時間並簡化生成式 AI 模型在雲端、資料中心和 GPU 加速工作站上的部署。它通過使用行業標準 API 抽象化 AI 模型開發和生產打包的複雜性,從而擴大了開發者群體。

NVIDIA NIM 用於優化的 AI 推理

NVIDIA NIM 旨在彌合 AI 開發的複雜世界與企業環境運營需求之間的差距,使 10 到 100 倍的企業應用開發人員能夠為公司的 AI 轉型做出貢獻。

NIM 的一些核心優勢包括以下幾點。

部署到任何地方

NIM 專為便攜性和控制而設計,能夠在各種基礎設施上部署模型,從本地工作站到雲端再到本地數據中心。這包括 NVIDIA DGX、NVIDIA DGX Cloud、NVIDIA 認證系統、NVIDIA RTX 工作站和 PC。

預先構建的容器和 Helm 圖表與優化模型打包,經過嚴格驗證並在不同 NVIDIA 硬體平台、雲服務提供商和 Kubernetes 分發版上進行基準測試。這使得在所有 NVIDIA 驅動的環境中都能提供支持,並確保組織能夠在任何地方部署其生成式 AI 應用程序,同時保持對其應用程序和處理數據的完全控制。

使用行業標準的 API 進行開發

開發者可以通過遵循各行業標準的 API 來訪問 AI 模型,從而簡化 AI 應用程式的開發。這些 API 與生態系統內的標準部署流程相容,使開發者能夠快速更新其 AI 應用程式——通常只需三行代碼即可實現。這種無縫整合和易用性促進了 AI 解決方案在企業環境中的快速部署和擴展。

利用特定領域的模型

NIM 也透過幾項關鍵功能來滿足領域特定解決方案和優化效能的需求。它打包了領域特定的 NVIDIA CUDA 函式庫,並針對語言、語音、視訊處理、醫療保健等各種領域量身定制了專用程式碼。這種方法確保了應用程式在其特定使用案例中的準確性和相關性。

在優化的推理引擎上運行

NIM 利用針對每個模型和硬體設置優化的推理引擎,在加速基礎設施上提供最佳的延遲和吞吐量。這降低了運行推理工作負載的成本,隨著規模的擴大,並改善了終端用戶的體驗。除了支持優化的社群模型外,開發者還可以通過對齊和微調模型與專有數據源來實現更高的準確性和性能,這些數據源永遠不會離開其數據中心的邊界。

支援企業級人工智慧

作為 NVIDIA AI Enterprise 的一部分,NIM 建立在企業級基礎容器之上,通過功能分支、嚴格的驗證、帶有服務水平協議的企業支持以及針對 CVE 的定期安全更新,為企業 AI 軟件提供了堅實的基礎。全面的支持結構和優化能力凸顯了 NIM 在生產中部署高效、可擴展和定制化 AI 應用的關鍵作用。

加速的 AI 模型已準備好部署

支援多種 AI 模型,例如社群模型、NVIDIA AI Foundation 模型,以及由 NVIDIA 合作夥伴提供的自訂 AI 模型,NIM 支援跨多個領域的 AI 應用案例。這包括大型語言模型(LLMs)、視覺語言模型(VLMs),以及用於語音、圖像、視頻、3D、藥物發現、醫學影像等領域的模型。

開發者可以使用來自NVIDIA API 目錄的 NVIDIA 託管雲端 API 來測試最新的生成式 AI 模型。或者,他們可以通過下載 NIM 自行託管這些模型,並在主要雲端供應商或本地使用 Kubernetes 快速部署,從而縮短開發時間、降低複雜性和成本。

NIM 微服務通過打包算法、系統和運行時優化,並添加行業標準 API,簡化了 AI 模型部署過程。這使開發者能夠將 NIM 集成到他們現有的應用程序和基礎設施中,而無需大量定制或專業知識。

使用 NIM,企業可以優化其 AI 基礎設施,以實現最大效率和成本效益,而無需擔心 AI 模型開發的複雜性和容器化問題。除了加速 AI 基礎設施外,NIM 還有助於提升性能和可擴展性,同時降低硬體和運營成本。

對於希望為企業應用定制模型的企業,NVIDIA 提供了跨不同領域的模型定制微服務。NVIDIA NeMo提供了使用專有數據進行微調的能力,適用於LLMs、語音 AI 和多模態模型。NVIDIA BioNeMo通過不斷增長的生成生物學化學和分子預測模型集合,加速藥物發現。NVIDIA Picasso 通過 Edify 模型實現更快的創意工作流程。這些模型在視覺內容提供商的授權庫上進行訓練,從而能夠部署定制的生成 AI 模型用於視覺內容創作。

開始使用 NVIDIA NIM

開始使用 NVIDIA NIM 既簡單又直接。在NVIDIA API 目錄中,開發者可以存取各種 AI 模型,這些模型可用於構建和部署他們自己的 AI 應用程式。

直接使用圖形用戶界面在目錄中開始原型設計,或免費使用 API。當您準備好在基礎設施上部署 NIM 微服務時,您可以自行託管 AI 基礎模型。

從 API 目錄中,您將被提示註冊 NVIDIA AI Enterprise 90 天訂閱許可證,完成後,您可以在自己的基礎設施上部署 NIMs。

欲了解更多詳情,請查看NVIDIA NIM 大型語言模型入門指南文件。

額外的 NIMs 將會持續發布以供自行託管。您可以透過API 目錄中的免費額度,存取 NVIDIA 託管的端點,用於應用程式原型設計,涵蓋廣泛的基礎模型。

NVIDIA NIM 是一個強大的工具,可幫助組織加速其生產 AI 的旅程。立即開始您的 AI 旅程。

相關資源

- DLI 課程:在生產規模上部署模型進行推理

- GTC 會議:加速企業:下一代 AI 部署的工具與技術

- NGC 容器:NV-CLIP

- NGC 容器:Phind-CodeLlama-34B-v2-Instruct

- NGC 容器:NVIDIA NIM Operator

- SDK: Triton 管理服務

NVIDIA NIM 與其他 AI 部署工具相比有何優勢?

與其他工具的主要差異

部署效率

- NIM通過預優化容器提供了顯著的性能提升,例如在Meta Llama 3-8B模型上可實現高達3倍的吞吐量提升

- 相較於傳統部署方法,NIM將部署時間從數週縮短至數分鐘

與vLLM的比較

- NIM作為更高層級的抽象工具,能自動選擇最佳推理引擎

- vLLM則是一個特定的推理引擎,可作為NIM框架內的後端選項之一

與NVIDIA NeMo的關係

- NeMo專注於AI模型的構建和自定義

- NIM則負責將模型部署到生產環境並在應用程序中運行

技術優勢

標準化API整合

- 採用行業標準API,如OpenAI API標準

- 開發者只需少量代碼即可快速更新AI應用

優化的推理引擎

- 自動為每個模型和硬件配置選擇最佳推理引擎

- 整合了NVIDIA TensorRT-LLM等優化工具

企業價值

成本效益

- 通過優化的推理性能降低運營成本

- 提高基礎設施利用率

安全性和可控性

- 提供自託管選項,確保數據安全

- 支持完整的監控和管理功能

生態系統支持

廣泛的合作夥伴網絡

- 超過150個合作夥伴提供生態系統支持

- 包括主要雲服務提供商和企業級解決方案供應商

多樣化的模型支持

- 支持40多個NVIDIA和社區模型

- 涵蓋文本、圖像、視頻等多個領域

NVIDIA NIM 如何簡化 AI 部署

部署簡化特點

容器化解決方案

- 使用預建的Docker容器和Helm圖表,可在5分鐘內完成部署

- 包含優化的運行時環境和預先驗證的模型

- 自動處理模型下載和硬體優化選擇

標準化API整合

- 提供符合行業標準的API介面

- 開發者只需約3行程式碼即可更新AI應用

- 支援多種領域特定的NVIDIA CUDA函式庫

部署靈活性

多平台支援

- 可在雲端、數據中心、RTX工作站和PC上運行

- 支援NVIDIA DGX、DGX Cloud和NVIDIA認證系統

- 提供本地部署選項,確保數據隱私和控制

Kubernetes整合

- 提供NIM Operator用於Kubernetes集群管理

- 支援兩種自定義資源定義:NIMService和NIMPipeline

- 自動化擴展和生命週期管理功能

效能優化

智能資源管理

- 支援並行處理以提高吞吐量

- 提供模型預緩存功能,加快初始推理速度

- 自動選擇最佳硬體加速和運行時環境

企業級功能

安全性和控制

- 完整的數據控制權和隱私保護

- 支援本地RAG管道執行

- 經過嚴格的效能基準測試和驗證

- 使用 NVIDIA NIM 和 NeMo 構建代理式 AI

- NVIDIA/k8s-nim-operator: An Operator for deployment and maintenance of NVIDIA NIMs and NeMo microservices in a Kubernetes environment.

- NVIDIA/nim-deploy: A collection of YAML files, Helm Charts, Operator code, and guides to act as an example reference implementation for NVIDIA NIM deployment.

NVIDIA NIM 與 Amazon SageMaker 的主要差異為何?

功能定位

- 專注於提供優化的AI推理微服務

- 提供預建容器和優化模型

- 主要針對NVIDIA GPU進行效能優化

- 作為推理加速工具,可整合到更大的平台中

- 提供完整的機器學習生命週期管理

- 包含模型訓練、部署和管理功能

- 支援多種硬體類型和框架

- 提供端到端的ML/AI開發環境

整合優勢

協同效益

- NIM可在SageMaker上將部署時間從數天縮短至數分鐘

- 透過SageMaker的NIM整合提供更好的價格效能比

- 支援包括Llama 2、Mistral-7b和Mixtral-8x7b等多種流行LLM模型

部署特點

NIM特性

- 提供預優化的容器和Helm圖表

- 專注於NVIDIA GPU的效能優化

- 包含TensorRT、TensorRT-LLM等NVIDIA專有技術

SageMaker特性

- 提供完整的基礎設施管理

- 支援藍綠部署和工作負載評估

- 整合Amazon CloudWatch監控功能

授權和可用性

NIM

- 作為NVIDIA AI Enterprise軟體平台的一部分

- 提供90天評估授權

- 需要通過AWS Marketplace取得授權

SageMaker

- AWS原生服務

- 按使用量計費

- 在所有AWS區域均可使用

以下是NVIDIA NIM的學習資源列表:

| 資源類型 | 標題 | 連結 |

|---|---|---|

| 官方課程 | Introduction to NVIDIA NIM™ Microservices | learn.nvidia.com/courses/course-detail?course_id=course-v1%3ADLI+S-FX-23+V1 |

| 官方課程 | Sizing LLM Inference Systems | learn.nvidia.com/courses/course-detail?course_id=course-v1%3ADLI+S-FX-18+V1 |

| 教學影片 | How to Deploy NVIDIA NIM in 5 Minutes | youtube.com/watch?v=087spL8hMvM |

| 教學影片 | NVIDIA NIM Beginners Guide - Generate Datasets Fast with Llama 3.1 | youtube.com/watch?v=vE80SLk-4PM |

| 教學影片 | Deploying Gen AI in Production with NVIDIA NIM & MLRun | youtube.com/watch?v=-vdOZRaKcvs |

| 官方文檔 | NVIDIA NIM for Large Language Models Tutorials | docs.nvidia.com/nim/large-language-models/latest/tutorials.html |

| 官方文檔 | Getting Started Guide | docs.nvidia.com/nim/large-language-models/latest/getting-started.html |

| 合作夥伴課程 | Generative AI with NIM and NeMo Overview (Lenovo) | lenovopress.lenovo.com/course/dainvd210 |

| 整合指南 | Deliver generative AI at scale with NVIDIA NIM on OpenShift AI | developers.redhat.com/articles/2024/11/12/generative-ai-nvidia-nim-openshift-ai |

| 開發者資源 | NVIDIA NIM for Developers | developer.nvidia.com/nim |

使用 NVIDIA NIM 可以執行哪些類型的 AI 任務

主要AI任務類型

語言處理

- 大型語言模型(LLM)應用

- 指令遵循和函數調用

- 聊天機器人和AI助手開發

- 程式碼生成和數學計算

視覺和多媒體

- 視覺語言模型(VLM)處理

- 圖像生成和編輯

- 3D引導的生成式AI創作

- 視頻處理和分析

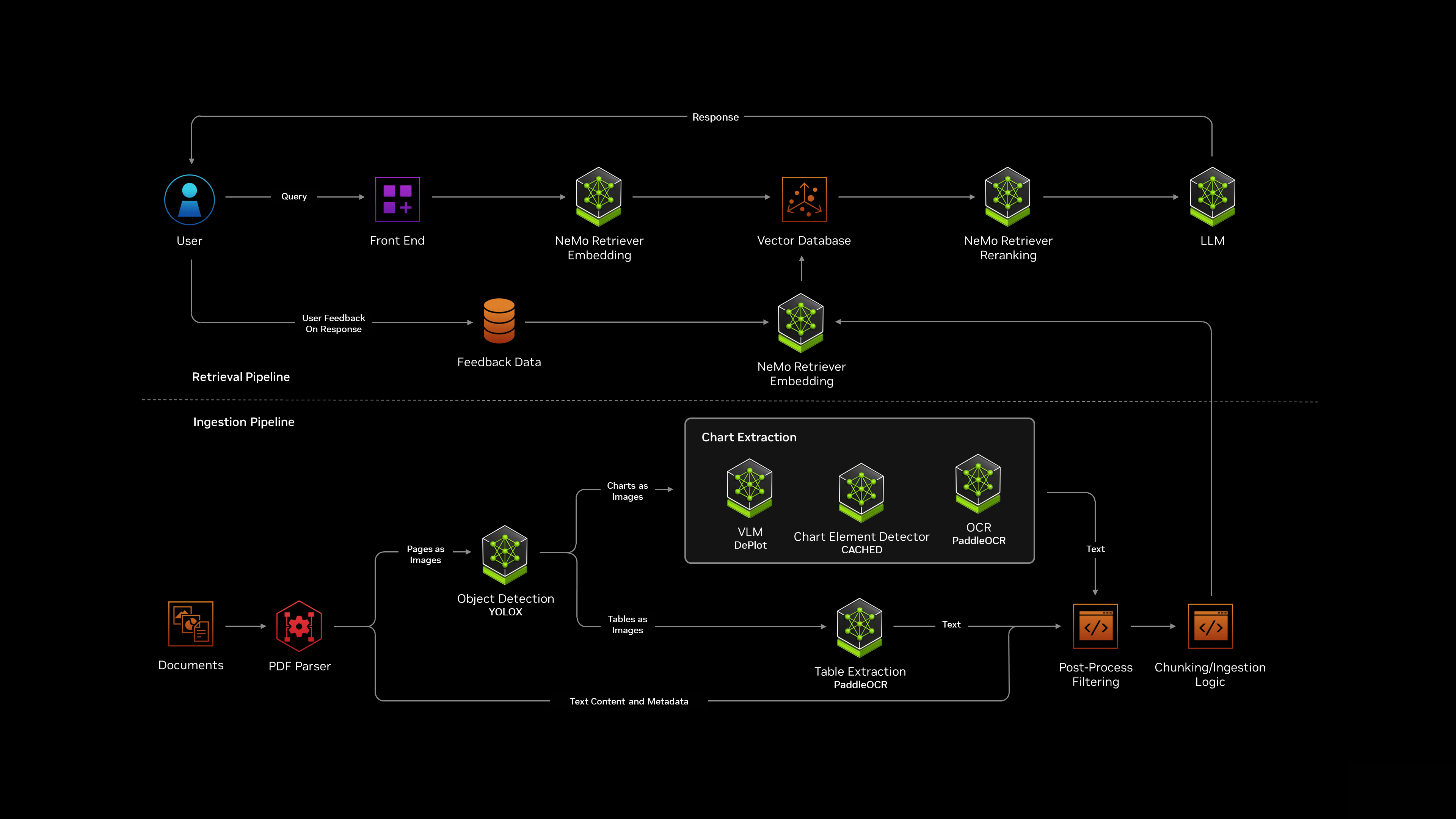

數據和文檔處理

- PDF文檔提取和分析

- 檢索增強生成(RAG)

- 嵌入模型應用

- 企業數據整合

專業領域應用

- 數位人類(Digital Humans)創建

- 生物醫學應用和藥物發現

- 醫學影像處理

- 分子預測和生成生物學

特殊功能

智能代理

- 專門訓練的代理行為模型

- Project R2X視覺化PC頭像

- 桌面應用程式輔助

- 視訊會議支援

創意工作流程

- 內容生成和創作

- 3D場景引導的圖像生成

- 視覺內容自定義

- 創意工作流程加速

企業應用

客戶服務

- 客戶服務虛擬助手

- 個性化用戶互動

- 多模態對話系統

- 自動化客戶支援

開發工具

- AI應用程式快速部署

- 模型優化和整合

- API標準化接口

- 企業級安全控制

NVIDIA NIM 如何與 RTX AI PC 整合

硬體支援

RTX 50系列整合

- 支援最新的GeForce RTX 50系列GPU

- 提供高達3,352兆次AI運算效能

- 配備32GB VRAM

- 首次在消費級GPU中支援FP4計算,使AI推理效能提升2倍

部署功能

簡化安裝流程

- 提供單鍵安裝功能

- 預先打包的微服務容器

- 在Windows 11 PC上通過Windows Subsystem for Linux (WSL)運行

- 從2025年2月開始提供支援

優化效能

- 針對Windows PC優化的微服務

- 支援跨NVIDIA GPU的部署優化

- 提供專業級AI功能於本地RTX系統

應用整合

開發工具支援

- 與主流AI開發框架無縫整合

- 支援AI Toolkit for VSCode, AnythingLLM, ComfyUI等工具

- 提供直觀的API介面

製造商支援

- 包括Acer, ASUS, Dell, HP等主要品牌

- Corsair, Origin PC等系統製造商提供NIM就緒的RTX AI PC

- 支援多種創意和開發工作流程

NVIDIA NIM提供多樣化的AI模型,涵蓋多個領域和應用場景:

大型語言模型

- Llama 3.1系列,包括405B和70B等版本,適用於指令遵循和數據生成

- Mistral和Mixtral模型

- NVIDIA Nemotron系列,專為代理AI任務優化

視覺和多模態模型

- NVIDIA Vila:理解文字和圖像的多模態視覺語言模型

- Consistory:生成連續一致的角色圖像

- Visual Changenet:檢測圖像間像素級別的變化

- NEVA-22B:處理文字和圖像的多模態模型

專業領域模型

- OCDRnet:用於光學字符檢測和識別

- Retail-object-detection:零售物件檢測,可識別100種特定零售物品

- BioNeMo:用於數位生物學和藥物發現

嵌入和排序模型

- NV-embed-v1:生成高質量文本數值嵌入

- Embed-qa-4:問答檢索的文本嵌入生成

- Rerank-qa-mistral-4b:為問答相關性評分優化的模型

創意和生成模型

- FLUX:用於3D引導的圖像生成

- Picasso:用於視覺內容創作的模型

這些模型通過NIM微服務提供,可在RTX AI PC、工作站、數據中心或雲端上運行。所有模型都經過優化,以確保在NVIDIA GPU上實現最佳性能和效率。

NVIDIA AI Blueprints 是什麼?

藍圖概述

NVIDIA AI Blueprints是預先訓練的AI工作流程,專為特定使用案例而設計。這些藍圖包含使用NVIDIA NIM和合作夥伴微服務建立的範例應用程式、參考程式碼、自訂文件和部署用的Helm圖表。

主要功能特點

- 提供預先配置的工作流程,可快速整合多個AI模型和功能

- 包含所有開發者需要的元件,包括參考應用程式、原始碼和文件

- 支援自訂和擴展現有工作流程

- 整合NVIDIA NIM微服務實現最佳效能

可用藍圖類型

零售與客服

- 零售購物助手藍圖:支援文字和圖像查詢,提供個人化購物建議

- 數位人類客服:使用NVIDIA Tokkio提供3D動畫人物介面

企業應用

- PDF轉播客藍圖

- 視訊搜索和摘要藍圖

- 虛擬篩選工作流程用於藥物發現

技術整合

與NIM的協同

- 藍圖使用NIM微服務作為核心運算引擎

- 支援多種模型服務,包括Llama 3.3 70B和NeMo Retriever

- 提供企業級安全性和效能優化

部署與擴展

- 透過Helm圖表實現快速部署

- 支援雲端和本地環境

- 提供完整的監控和管理功能

企業價值

- 加速AI應用開發週期

- 降低技術門檻

- 提供可立即使用的解決方案

- 支援持續改進的資料飛輪機制

更多關於 Nvidia Blueprints

- AI 基礎模型與端點 | NVIDIA

- NVIDIA 推出適用於 RTX AI PC 的 AI 基礎模型 | NVIDIA 新聞室

- NIM Serverless Inference API - a nvidia Collection

- Try NVIDIA NIM APIs

- NVIDIA 宣布 AI 零售購物助理藍圖 | NVIDIA 新聞室

- NVIDIA-AI-Blueprints/ai-virtual-assistant

- NVIDIA 與全球合作夥伴推出 NIM Agent 藍圖,讓企業打造自己的 AI

- NVIDIA-AI-Blueprints/digital-human

- 藍圖 | 快速邁向生成式人工智慧 | NVIDIA — Blueprints

- NIM 開發技術 Blog

常見問題 (FAQ)

1. 什麼是 NVIDIA NIM?它的主要用途是什麼?

NVIDIA NIM 是一套專為加速生成式 AI 模型部署而設計的微服務工具。透過高效的推論能力,它可以幫助企業在雲端、本地數據中心、RTX AI 個人電腦及工作站上快速運行 AI 模型,轉化為實際應用並創造商業價值。

2. NVIDIA NIM 如何簡化生成式 AI 的部署過程?

NVIDIA NIM 使用容器化方案,包括預建的 Docker 容器和 Helm 圖表,讓技術團隊可以在 5 分鐘內完成部署。此外,它提供標準化 API 與自動硬體優化選項,大幅降低了部署生成式 AI 模型的技術門檻與複雜度。

3. NVIDIA NIM 支援哪些 AI 應用場景?

NVIDIA NIM 支援多種應用,包括:

- 聊天機器人與虛擬助理

- 內容生成與摘要

- 語言翻譯與情感分析

- 藥物發現與醫學影像處理

- 創意工作流程,如 3D 圖像生成

4. NVIDIA NIM 與 Amazon SageMaker 有何不同?

NVIDIA NIM 專注於 AI 推理的微服務,提供針對 NVIDIA GPU 的高度優化模型,而 SageMaker 則為端到端的機器學習平台,涵蓋模型訓練、部署和管理。此外,透過整合使用 NIM,可以顯著縮短 SageMaker 模型的部署時間。

5. 如何開始使用 NVIDIA NIM?

開發者可從 NVIDIA API 目錄中選擇所需的 AI 模型進行測試,或直接下載 NIM 容器,在本地 Kubernetes 集群中自行托管並部署。此外,NVIDIA 提供了 90 天的 AI Enterprise 評估授權供企業試用。