由Google支持的AI新創公司Runway開發了AI圖像生成器Stable Diffusion,並且在六月初發布了Gen-2模型,是一個根據文本提示或現有圖像生成影片的模型。Gen-2 以前只能在有限的候補名單中排隊使用,但現在已經開放給所有用戶做使用,Runway 目前提供大約 100 秒的免費視頻生成,每個影片約4秒左右。

下面兩個是Runway官方所釋出的宣傳影片,畫面的流暢及細緻度還是令人非常驚嘆!Roundway 與許多生成式AI模型一樣,Gen-2所製作的影片中,人物可能會看起來極度不自然及不真實,但除了人物之外,風景及物件類的影片是非常令人佩服。

Experimenting with focal depth in prompts to shoot macro with Gen-2. pic.twitter.com/d3aSoeCmST

— Runway (@runwayml) June 1, 2023

與許多生成式AI模型一樣,Gen-2所製作的影片中,人物可能會看起來極度不自然及不真實。

雖然目前用 AI 生成影片的方法並不少,像是前幾天為大家介紹的 D-ID及HeyGen都是通過圖像來生成數位人影片,或是還有利用 Stable Diffusion WebUI 配合各種外掛工具實現的影片都需要圖像或者影片作為參考樣本才能生成新的影片,目前可以直接根據文本生成影片且質量如此之高的目前應該也只有Runway的Gen-2了吧。下面為大家介紹Gen-2的使用方法。

如何用Gen-2來製作影片?

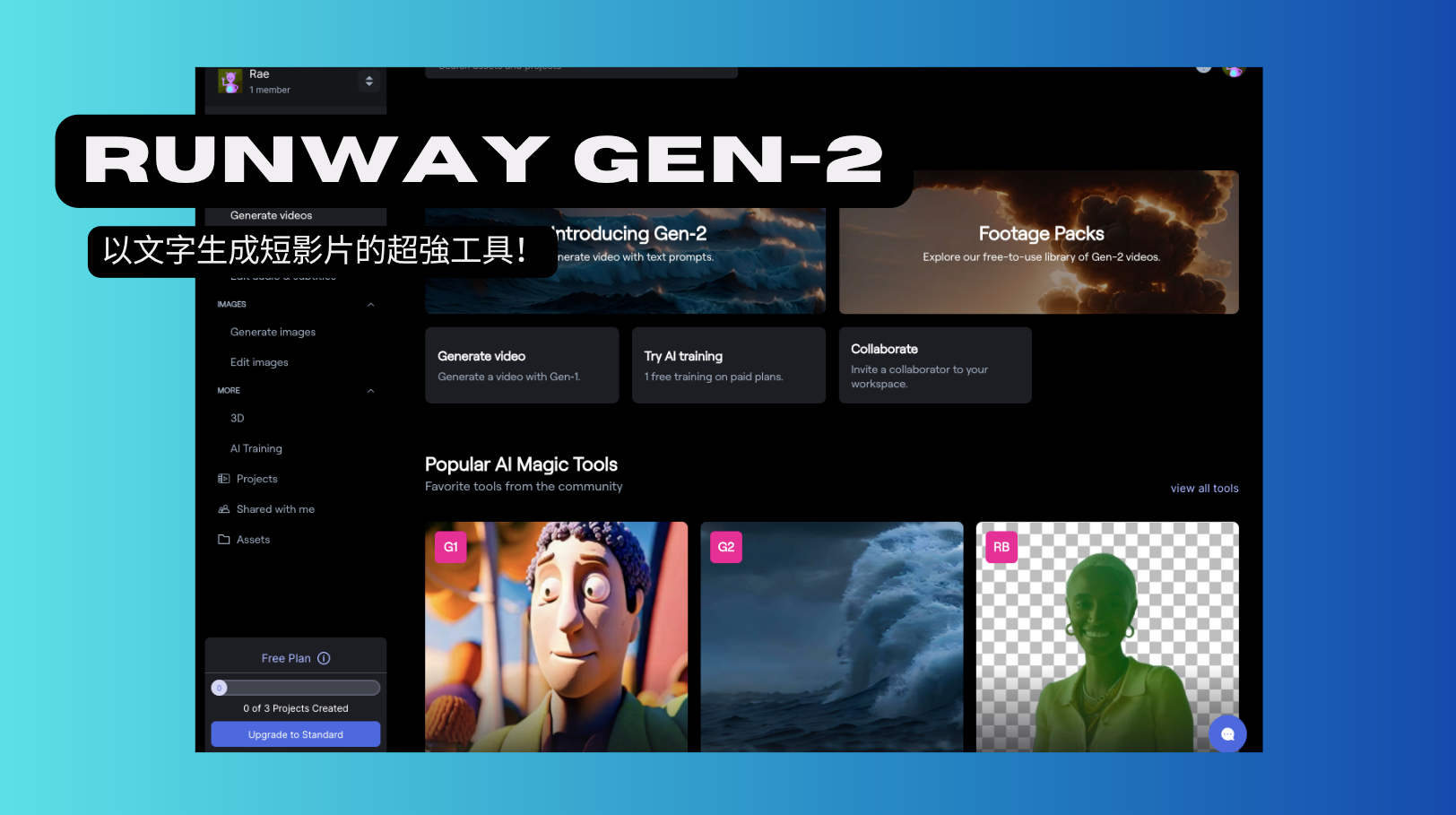

Runway官網:https://runwayml.com/

第一步: 註冊完成後會進到工作版,點選下方的Gen-2 Text to Video。

第二步: 在文字框內輸出英文提示描述想要的場景,然後點擊右側的「Generate」生成影片。如果不確定想要什麼內容,可以從其他算過圖的地方找靈感,或是參考別人的prompt來嘗試。

雖然只能夠生成4秒左右的影片,約需要等 30 秒以上,速度跟品質已經是非常理想的狀態了!

IG 影片中我們所使用的Prompt是"Couple in night clubs hugging in night club, in the style of dark teal and light amber, commentary on race, narrative-driven visual storytelling, yankeecore, rtx on, thomas dodd, gentle expressions"

結論

每天不斷體驗各種AI工具,我深刻體會到AI技術對我們工作方式的改變。雖然目前以文字生成影片在時長、清晰度和準確性等方面仍有不足,但我們見證了AI繪畫的驚人進步,從畫不出臉到以假亂真只花了幾個月的時間。這讓我對AI影片技術的未來充滿信心,相信它必將更加發達。

當AI影片技術成熟起來,它將為藝術家、動畫和電影愛好者以及影片內容創作者帶來全新的創作方式。它將改變影片和影視製作行業,讓我們能以更豐富、創新的方式表達故事和想法。我迫不及待地期待那個未來的時刻,當我們能夠運用AI技術打破界限,探索更廣闊的創作領域。