DeepSeek 強勢崛起,震驚美國股市!它真能威脅 NVIDIA 的 AI 晶片霸主地位?深入剖析 DeepSeek 的實力與潛在影響。

幻化量方實驗室「Deepseek」近期發布的開源大型語言模型,如何在短短兩個月、僅約 560 萬美元的成本下,達到媲美甚至超越美國部分大模型(如 OpenAI、Anthropic、Meta)性能的成果,並剖析其對美國在 AI 產業領先地位所帶來的挑戰與影響。

概述

DeepSeek 公司最新開源的大型語言模型,並討論其技術特色、訓練流程,以及對美股、對 NVIDIA 等大廠的潛在衝擊。以下我們將介紹人工智慧領域的一些核心概念,如訓練 (Training)、推論 (Inference)、大型語言模型 (LLM) 的開發流程,以及強化學習 (Reinforcement Learning)、知識蒸餾 (Knowledge Distillation) 等技術。

一、DeepSeek 模型的關鍵特色

- 更低的運算資源需求

- DeepSeek 官方聲稱其模型的訓練只需過去大型模型約 1% 的運算量即可達到相近的性能。雖然實際數據可能未必達到 1%,但推估仍可大幅降低算力需求(如 10%~20%)。

- 這意味著在訓練與推論階段,都能用較少的 GPU 或硬體資源完成類似的 AI 訓練任務。

- 強化學習導向的推論能力

- DeepSeek 的模型特別強調推論能力(例如數學、程式邏輯)的提升,透過大規模強化學習使模型在邏輯推理上表現卓越。

- 採用「羣體相對策略優化 (Group Relative Policy Optimization, GRPO)」來取代傳統 PPO 的「評論器 (Critic)」機制,使訓練更有效率、結果更穩定。

- 開源並提供高品質資料

- DeepSeek 開源了模型,也釋出了可用於「知識蒸餾」的高品質資料。

- 其他開源大模型(如阿里巴巴的 Qwen、Meta 的 Llama 等)都可以利用這些資料進行蒸餾,讓參數較小的模型仍保有不錯的推論表現。

Deepseek 的關鍵突破

- 低成本、高效率的訓練

- 訓練成本:Deepseek 表示只花了約 560 萬美元,並在短短 2 個月內完成第三版模型的訓練。

- 硬體條件:在美國對中國的高階 GPU(如 Nvidia H100)輸出管制下,Deepseek 只能使用更受限的 H-800 GPU 卻依然成功訓練出效能強大的模型。

- 對比:OpenAI 每年支出高達 50 億美元;Google 在 2024 年的資本支出可能超過 500 億美元;Microsoft 投資 OpenAI 超過 130 億美元。Deepseek 與之相比,成本與資源使用量可謂「極度精簡」。

- 模型性能表現突出

- Deepseek 的大型語言模型(v3 版本,以及後續的 R1「推理模型」)在多項基準測試,如數學題解題、程式碼撰寫與除錯等,超越或逼近美國大廠模型(Meta 的 Llama、OpenAI 的 GPT-4-O、Anthropic 的 Claude Sonnet 3.5)。

- 全新推理模型 R1 在某些第三方測試中,同樣勝過或追平美國最新的大模型。

- 對美國輸出管制的「反直覺」結果

- 美國原先期待切斷中國對高階晶片的取得,藉此拖慢中國 AI 的進程。

- Deepseek 卻在有限條件下促進了演算法與訓練策略的創新,反而快速趕上甚至超越某些美國模型,顯示「必要性促發創新」。

二、人工智慧基礎概念複習

- 訓練 (Training) 與推論 (Inference)

- 訓練:利用大量的數據進行學習,計算並更新模型的「參數 (權重)」。

- 推論:使用已訓練好的參數,對新輸入進行預測或生成答案。

- 人工神經網路 (ANN) 與參數

- 模擬人類神經元與突觸放大倍數的數學架構,所有圈圈(神經元)與箭頭(突觸)的「權重 (Weights)」通常都是浮點數。

- 「大型語言模型的參數量」指的正是權重的數量。越大的模型,表示擁有更多的突觸/權重需要更新與儲存。

- 大型語言模型 (LLM) 一般訓練流程

- 預訓練 (Pre-training):使用無標註的海量語料進行訓練,讓模型學到語言的基本模式。

- 微調 (Fine-tuning):再用少量已標註的高品質數據,做進一步的監督式學習,使模型在特定任務上表現更精準。

- 強化學習 (Reinforcement Learning):讓模型自行探索、嘗試錯誤,並根據「獎勵」或「懲罰」來更新策略,進一步改善模型對複雜推論的能力。

三、DeepSeek 模型的技術與訓練流程

- 多階段訓練方法

- 結合「監督式微調 (Supervised Fine-tuning)」與「強化學習 (RL)」的雙重流程。

- 透過「冷啟動微調 → 推論導向的強化學習 → 第二次監督微調與強化學習」的反覆訓練,使模型在深層推論與可讀性之間取得平衡。

- 羣體相對策略優化 (Group Relative Policy Optimization, GRPO)

- 不使用傳統強化學習中的評論器 (Critic),而是靠「同一批生成答案」的相互比較,選出最佳/較佳答案並予以獎勵。

- 好處:減少計算成本、避免評論器失誤導致模型收斂困難,特別適用在數學、程式等有明確對錯判斷的領域。

- 知識蒸餾 (Knowledge Distillation)

- 將大模型(教師模型)所學到的知識轉移給小模型(學生模型),讓小模型用更少參數仍保有高效能。

- DeepSeek 釋出高品質的蒸餾資料,其他開源模型如 Qwen、Llama 等也可透過蒸餾得到類似或更佳的推論表現。

四、實驗結果與對比

- 在多項基準測試中,DeepSeek 與 OpenAI GPT 系列分庭抗禮

- 在十一個測試項目中,有部分項目超越 OpenAI GPT,也在程式碼與數學領域展現非常接近甚至勝出的表現。

- 蒸餾效益明顯

- 即使是 70 億參數的學生模型(如 Qwen),經 DeepSeek 提供的高品質資料蒸餾後,其表現可逼近甚至超過原本的 130 億或更多參數的大模型。

- 說明「資料品質」與「訓練方法」的重要性,並不是單純「參數多就更強」。

五、對市場與未來發展的影響

- 潛在衝擊

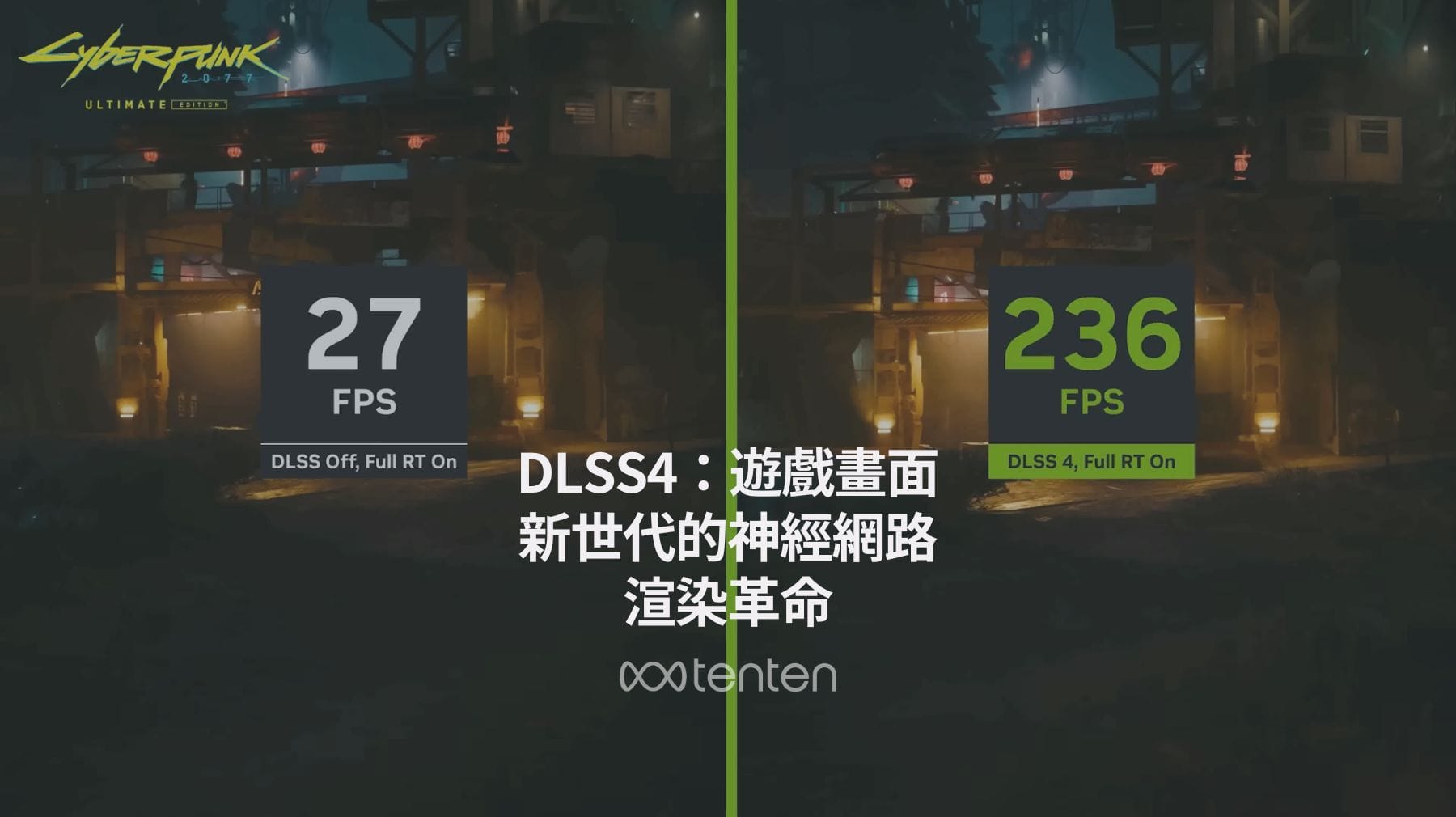

- 如果 DeepSeek 開源模型在實際測試中真能大幅降低算力需求,將可能影響 NVIDIA 等高階 GPU 供應商的長期市場需求。

- 同時也顯示大型語言模型發展不一定要「越做越大」,而是追求「高效率」、「高品質資料」與「優化的訓練策略」。

- 應用層面

- 模型推論能力(例如數學解題、程式碼生成)或多模態應用都可能更「平民化」,讓中小型企業或個人開發者也能負擔起訓練與部署。

- 適用於各種領域的客製化模型將更容易取得,可能加速 AI 在產業與日常生活中的普及。

- 開源社群的發展

- 提供高品質的蒸餾資料與技巧,促進其他開源模型的演進,並孵化更多元創新應用。

- 強化學習與知識蒸餾技術持續精進,未來多模態(文字、圖像、語音、影片)或多工任務的模型也會從中受益。

Deepseek 實驗室與中國 AI 生態

- Deepseek 的神秘背景

- Deepseek 由名為梁文峰(Liang Wenfeng)的研究者創立;背後據傳與一家約管理 80 億美元資產的對沖基金「High Flyer Quant」有關。

- 官方對外公開資訊不多,其開源版本的聲明僅簡短提及「探索通用人工智慧(AGI)的奧秘」。

- 中國其他 AI 實力

- 李開復的「Zero One Dot AI」:短短八個月即成為獨角獸,2024 年營收約 1400 萬美元。

- 阿里巴巴的 Qwen:大幅壓縮大模型訓練成本,費用可降低約 85%。

- 這些案例都展現中國在高成本與算力受限之下,仍有高度競爭力與創新能力。

- 美中 AI 競爭格局的轉變

- 前 Google 執行長 Eric Schmidt 早先預估中國比美國落後 2~3 年,但他近期表示過去半年間中國進步「令人驚訝」,特別提到 Deepseek。

- 這意味著美國原本被視為「遙遙領先」的地位,如今已受到中國 AI 模型的明顯挑戰。

對美國各大 AI 業者的衝擊

- OpenAI 的壓力

- OpenAI 與 Deepseek 的分歧:OpenAI 強調前沿模型需要龐大資金與資源,然而 Deepseek 卻用微乎其微的成本達到類似水準。

- CEO Sam Altman 曾在 Deepseek 模型發布後,於推特暗示「複製原有成果容易,但做真正創新很難」。

- 然而業界普遍認為 Deepseek 並非單純「抄襲 ChatGPT」,而是整合了公有語料、ChatGPT 產出內容以及自研演算法優化,實際上具備相當創新性。

- Meta、Anthropic、Google 等的應對

- Meta:以開源的 Llama 模型吸引用戶,但如今 Deepseek 的開源成效與低成本更勝一籌,Meta 未來可能也會參考 Deepseek 的技術細節。

- Anthropic、Google:同樣面臨「是否要投入更多資源於封閉式大模型,或是尋求更高效訓練方法」的抉擇。

- 開源模型對產業生態的影響

- Deepseek 開源後,大量開發者可直接使用或進行「知識蒸餾 (distillation)」和微調,快速開發應用。

- 開源模型一旦「趕上或超越」封閉模型,吸納開發者的速度會非常快,導致商業模式與技術生態發生巨大轉變。

訪談:Perplexity CEO Arvind Srinivas 的觀點

CNBC 專訪了 Perplexity 的共同創辦人兼 CEO Arvind Srinivas,以下為核心觀點:

- 中國的創新與「必要性」

- Arvind 認為美國對中國的半導體管制,逼使中國科研人員在受限的硬體上尋求更高效解法,最終可能誕生更創新的訓練方法。

- Deepseek 成功運用 Mixture of Experts、低精度(FP8)訓練等技術,大幅解決了穩定度與資源不足的難題。

- 「抄襲」與「創新」的交互

- 雖然很多人認為中國模型只是在抄襲 OpenAI 的基礎,但實際上 Deepseek 融合了自己的改良並成功開源。

- Arvind 指出,在 AI 領域,「大家都在互相借鑒與演進」,包括最早是 Google 提出 Transformer,OpenAI 將其產品化等。

- 對美國開發者與市場的衝擊

- 開源的威力:如果 Deepseek 繼續保持開源,且性能與價格兼具優勢,將吸引美國大量開發者紛紛採用。這對 OpenAI 及其他封閉式模型造成嚴峻挑戰。

- AI 應用層的改變:對於像 Perplexity 這樣的應用服務,能以更低成本整合 Deepseek 模型,同時降低對封閉商業 API 的依賴。

- OpenAI 如何自保?

- OpenAI 可能重心轉向更高階的「推理 (reasoning)」能力,企圖以龐大資源追求前所未有的性能與功能,建立新一輪壁壘。

- 然而,Arvind 也認為「推理」模型可能很快被其他團隊(包括 Deepseek)學習或複製,再次出現低成本趕超的情況。

- Perplexity 自身的策略

- 不與大廠在大模型訓練上正面競爭,而是集中資源在「最終應用層」和「使用者體驗」,利用市面上(包括 Deepseek)的各種優秀模型並加以整合。

- 目前也嘗試使用廣告(Ads)營利模式,但會謹慎平衡使用者體驗與真實性。

結論

- Deep Seek 1% 算力的宣稱

- DeepSeek 公司雖然表示只需過去約 1% 的算力,但實際效果可能仍有落差。即使如此,也顯示出藉由先進訓練策略和高品質資料,可在更少的硬體成本下取得不俗的 AI 表現。

- 核心三要素

- AI 的關鍵不僅在「硬體算力」,還包括:

- 演算法與技術的改良(如 GRPO、知識蒸餾、增強推論能力)

- 高品質且充足的資料集

- 強大的算力支援

- 三者結合才能在 AI 競賽中占據優勢。

- AI 的關鍵不僅在「硬體算力」,還包括:

- 未來觀察重點

- 歐美研究機構與產業對 DeepSeek 模型的實際測試成果及迴響(預估幾週內會陸續發表)。

- 模型開源後,衍生的衍生版或蒸餾版是否能在實際應用中展現與大模型相當的效果。

總之,DeepSeek 的新模型若能真的在「高推論能力」與「低算力需求」之間取得顯著平衡,對整個 AI 產業的影響不容小覷。未來發展與測試結果值得持續關注。

More about Deepseek

- 實測 OpenAI o3 Mini:單挑 DeepSeek R1,誰是 AI 模型性能之王?

- 開源 DeepSeek-R1 模型:挑戰 OpenAI 的推理新星

- OpenAI o1 遇上勁敵 DeepSeek-R1:AI 技術的新戰場!

- Deepseek V3 + Bolt DIY - AI 開發神器

- DeepSeek模型分析:AI界的新勢力崛起

FAQ

常見問題 (FAQ)1. DeepSeek 模型如何降低算力需求?

DeepSeek 模型利用創新的訓練方法(如羣體相對策略優化 GRPO)和高品質資料集,使得其訓練只需過去大型模型約 1% 的算力,甚至在有限硬體資源(如 NVIDIA H-800 GPU)下也能達到強大性能。

2. DeepSeek 模型在性能上是否超越 OpenAI 或其他大廠模型?

在多項基準測試中,DeepSeek 的大型語言模型表現突出,特別是在數學解題、程式碼生成等領域,部分測試結果超越 OpenAI GPT-4-O 和 Meta 的 Llama。

3. DeepSeek 為什麼對 NVIDIA 的市場地位構成潛在威脅?

DeepSeek 模型大幅降低了算力需求,這可能使得對高階 GPU 的需求下降,對 NVIDIA 長期的市場需求產生挑戰,特別是在人工智慧領域的應用中。

4. DeepSeek 採用了哪些技術突破?

DeepSeek 結合了多階段訓練方法,包括監督式微調、強化學習(如 GRPO),以及知識蒸餾技術,能以更少參數實現高效推論能力,並釋出高品質蒸餾資料供開源模型使用。

5. DeepSeek 對開源模型的影響是什麼?

DeepSeek 開源後,其釋出的高品質資料與技術促進了其他開源模型(如 Meta 的 Llama 及阿里巴巴的 Qwen)的發展,使得開源技術生態更趨成熟,並降低 AI 技術普及的門檻。