AMD 推出 ROCm 生態系,試圖挑戰 NVIDIA CUDA 的市場地位。本文分析 ROCm 的優勢與未來發展潛力。

軟體生態系統發展

- ROCm開源軟體平台是AMD的核心戰略,這個平台支援PyTorch 2.0和TensorFlow等深度學習框架

- 最新版本ROCm 6.2引入了新的FP8格式支援、Flash Attention 3和Kernel Fusion功能,提供2.4倍的推理性能提升

硬體效能提升

- 新推出的Instinct MI325X晶片具備:

- 256GB HBM3E記憶體

- 6 TB/s記憶體頻寬

- 在Meta的Llama 3.1 AI模型上比Nvidia H200快40%

策略合作夥伴關係

- 與主要科技公司建立合作關係,包括:

- Meta (使用超過150萬個AMD EPYC CPU和Instinct GPU)

- Google Cloud

- Microsoft Azure

- Oracle Cloud Infrastructure

產品路線圖

- MI350系列預計在2025年推出,承諾:

- 比MI300X提供35倍的推理性能

- 288GB HBM3E記憶體

- 8 TB/s記憶體頻寬

市場佈局

- 分析師預測AMD有機會在長期內獲得20%的AI晶片市場份額

- 採取更實惠的價格策略,同時提供與Nvidia相當的硬體性能

研發投資

- 在過去一年投資超過10億美元用於改善AI軟體能力和研發活動

- 收購多家軟體公司(Silo AI、Nod.ai和Mipsology)以增強其軟體抽象層次

儘管目前Nvidia在GPU搭載的AI伺服器市場佔有率接近90%,而AMD僅約8%,但透過這些全方位的策略,AMD正逐步建立其在AI運算市場的競爭力。

AMD 的 ROCm 與 Nvidia 的 CUDA 在開發人員採用方面的比較如何?

開發者生態系統差異

AMD的ROCm與Nvidia的CUDA在開發者採用方面存在顯著差距:

Github關注度

- Nvidia的Github擁有6,700位追隨者

- AMD ROCm僅有800位追隨者

文檔與使用者體驗

- CUDA提供完整的文檔和廣泛的開發工具支援

- ROCm的文檔品質較差,存在不正確或不完整的資訊問題

效能表現

- 在隨機數生成庫的測試中:

- ROCm版本比CUDA慢37%

- 在2D布朗運動模擬中慢48%

相容性解決方案

- AMD開發了ZLUDA項目:

- 允許未修改的CUDA應用程式在ROCm上運行

- 某些情況下性能優於原生ROCm/HIP移植版本

- 在Blender 4.0渲染測試中快10-20%

開發環境差異

- CUDA:

- 從筆記型電腦到伺服器GPU都可使用相同環境

- 開發流程更加順暢

- ROCm:

- 桌面使用RDNA架構

- 資料中心使用CDNA架構

- AMD已擴展ROCm支援至部分7000系列顯卡以改善開發管道

抽象層次趨勢

- 大多數開發者現在傾向於使用更高層次的框架如PyTorch

- 直接使用CUDA核心程式設計的開發者相對較少

從 CUDA 轉換到 ROCm 時,開發人員面臨的主要挑戰是什麼?

開發工具與文檔問題

- ROCm文檔品質較差,存在不正確或不完整的資訊

- 缺乏完整的開發工具支援,相比CUDA的生態系統較為薄弱

相容性挑戰

- 某些CUDA特定功能在ROCm中沒有直接對應項

- 不同ROCm版本之間存在向後相容性問題,例如ROCm 6.0與5.x系列不相容

- 驅動程式相容性問題,如ROCm 5.7的DKMS模組無法在Linux 6.5內核上構建

依賴項管理困難

- Python套件管理複雜,常見問題包括:

- 安裝程序可能會自動安裝CUDA版本而非ROCm版本

- 需要特定版本的Python、PyTorch等套件才能正常運行

效能問題

- 在某些應用場景中效能低於CUDA:

- 隨機數生成庫比CUDA慢37%

- 2D布朗運動模擬慢48%

生態系統限制

- 框架支援不如CUDA全面

- 社群支援相對較少,解決問題的資源有限

- 容器映像更新較慢,許多現有映像已過時

開發環境差異

- 需要在不同硬體架構間切換:

- 桌面使用RDNA架構

- 資料中心使用CDNA架構

- 測試環境建置較為複雜

就大規模部署而言,AMD GPU 的成本與 Nvidia GPU 相比如何?

硬體價格差異

- AMD MI300X的定價明顯低於Nvidia:

- MI300X售價約$10,000-15,000

- H100售價高達$30,000-40,000

- Microsoft作為大客戶可以以約$10,000的價格取得MI300X

雲端部署成本

- RunPod雲端平台上的每小時費率:

- H100 SXM: $4.69/小時

- MI300X: $4.89/小時

效能成本比

- 在小批量處理(batch size 1-4)時:

- MI300X: 每百萬tokens成本$11.11-22.22

- H100: 每百萬tokens成本$14.06-28.11

總體擁有成本考量

- Nvidia H100包含:

- 5年商業AI軟體授權

- 較高的轉售價值

- AMD MI300X優勢:

- 更大的記憶體容量(192GB vs 80GB)

- 更高的記憶體頻寬(5.3 TB/s)

- 在某些AI工作負載中性能提升30%

電力效率

- Nvidia整體能源效率較佳:

- H100 TDP: 350W

- MI250X TDP: 500W

- 這可能影響長期運營成本,特別是在大規模部署中

與 CUDA 相比,ROCm 的社群支援如何?

開發者社群規模差異

- Nvidia CUDA擁有:

- 超過200萬註冊開發者

- 每月438,000次CUDA下載量

- 每月100,000次開發工具下載量

- AMD ROCm社群相對較小,面臨以下挑戰:

- 開發過程不夠開放透明

- 社群參與度較低

- 問題追蹤系統回應不及時

ROCm 的開發者社群

開源協作模式

- CUDA生態系統:

- 提供完整的開發者論壇

- 有專門的工程師團隊回答技術問題

- 擁有專屬的錯誤追蹤系統

- ROCm開源模式:

- 雖然代碼開源,但開發決策較不透明

- 硬體支援決策缺乏社群參與

- 社群反饋追蹤系統最近才建立

技術支援品質

- CUDA提供:

- 詳細的技術文檔

- 定期的開發者培訓

- 豐富的範例代碼

- ROCm支援較為有限:

- 文檔品質不一致

- 技術支援資源較少

- 社群解決方案分享不足

硬體支援政策

- CUDA:

- 提供長期硬體支援(8年以上)

- 向後相容性較好

- ROCm:

- 硬體支援週期較短

- 舊卡支援政策變動較頻繁

- 缺乏明確的硬體支援時程表

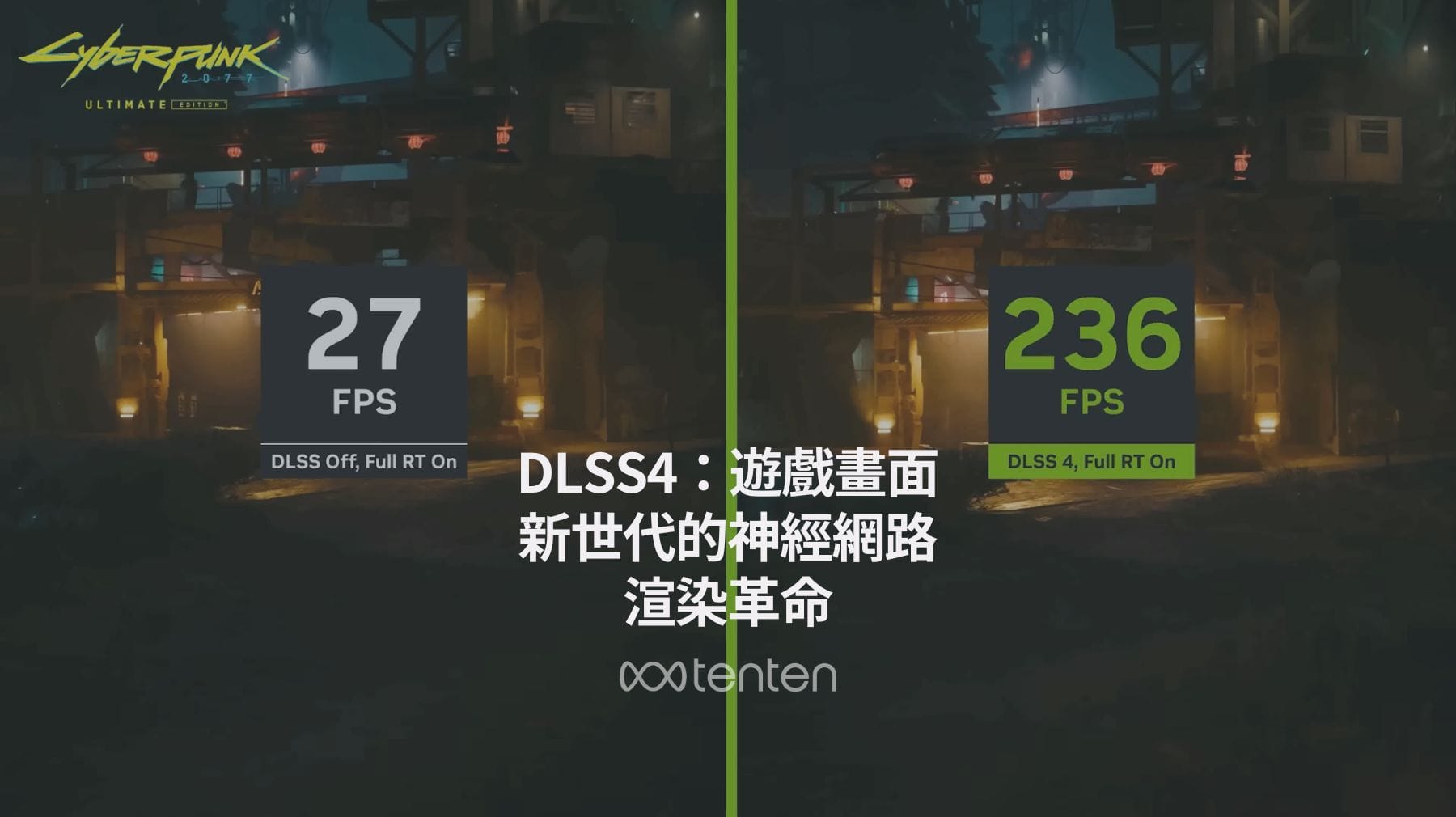

ROCm 與 CUDA 在 AI 應用程式上的效能差異為何

效能差異概述

- ROCm在多個基準測試中表現落後於CUDA:

- 光線追蹤程式慢37%

- 2D布朗運動模擬慢48%

- 隨機數生成庫性能較差

AI工作負載表現

- 模型使用情境:

- 預訓練模型直接使用:MI300X表現優異

- 微調現有模型:AMD表現良好

- 從頭訓練新模型:AMD表現較差

硬體效能比較

- MI300X與H100對比:

- MI300X在小批量處理時每百萬tokens成本$11.11-22.22

- H100在相同條件下每百萬tokens成本$14.06-28.11

- MI300X在某些AI工作負載中性能提升30%

效能瓶頸原因

- 軟體優化不足:

- 許多機器學習庫主要針對CUDA優化

- ROCm缺乏針對特定硬體的優化

- 回歸測試和整體測試覆蓋率不足

開發工具影響

- CUDA提供更完整的性能分析工具

- ROCm的除錯和性能優化工具相對有限

- 缺乏針對AMD硬體的特定優化指南

哪些公司使用 AMD 的 GPU 和 ROCm 進行 LLM 開發和培訓

| Company Name | Use Case | Hardware Configuration | Notable Achievements | Challenges Faced |

|---|---|---|---|---|

| Meta | Training large language models (LLMs) such as Llama 210 | AMD Instinct MI300X GPUs11 | Development of Llama 2 model recognized for generative AI capabilities12 | Software limitations and bugs within the ROCm platform affecting performance13 |

| training and fine-tuning of LLMs14 | AMD Radeon RX 7900 XTX and Radeon PRO W7900 GPUs15 | Successful adaptation of Liger Kernels to AMD GPUs, achieving up to 26% increase in multi-GPU training throughput and up to 60% reduction in memory usage.16 | Limitations in driver support and performance compared to NVIDIA GPUs; issues with memory management on certain hardware configurations.17 | |

| Microsoft | fine-tuning large language models (LLMs)14 | AMD Instinct MI300X GPUs18 | First cloud provider to offer MI300X GPUs for AI training and inference, enhancing performance for customers like Hugging Face.19 | Software limitations with ROCm compared to NVIDIA's CUDA, leading to performance issues and instability in certain environments.13 |

| Lamini | fine-tuning large language models (LLMs)20 | 128 AMD Instinct MI250 GPUs21 | Achieved software parity with Nvidia's CUDA for LLMs; developed the LLM Superstation for efficient finetuning of large models.14 | Complexity of distributed training and ensuring performance across multiple GPUs.22 |

| Moreh | Training large language models (LLMs)23 | 1200 MI250 GPUs24 | Successfully trained a 221 billion parameter Korean language model, the largest to date, outperforming NVIDIA's A100 in performance metrics.25 | Initial lack of a well-established software stack for AMD GPUs; challenges with multi-GPU configurations and software stability.23 |

| Databricks | Training large language models (LLMs) for tasks such as text generation and sentiment analysis.24 | AMD MI250 GPUs, with deployments of up to 1200 GPUs in some cases.26 | Achieved a 1.13x improvement in training performance using ROCm 5.7 compared to earlier versions.24 | Limited developer ecosystem for ROCm, leading to slower development and bug fixes compared to CUDA.27 |

主要採用趨勢

- 大型科技公司採用率上升,特別是Meta、Microsoft和Google的加入顯示市場信心增強

- AI新創公司如Lamini和Moreh也開始採用AMD解決方案

採用規模

- Moreh使用1,200個MI250 GPU訓練2,210億參數的韓語模型

- Databricks部署多達1,200個GPU的大規模集群

- Lamini運行128個AMD Instinct GPU的超級運算站

市場分布

- 資訊科技服務業佔12%

- 醫療設備產業佔6%

- 石油能源產業佔6%

- 57%的客戶來自美國,18%來自英國,7%來自印度

Meta 使用 AMD GPU 對其 LLM 效能有何影響?

部署規模與效能

- Meta目前將100%的Llama 3.1 405B模型運行在AMD MI300X GPU上

- 在16K個GPU同時訓練時,可達到每個GPU超過400 TFLOPS的運算效能

- 使用了兩個客製化的24K GPU叢集進行訓練

技術優勢

- MI300X的優勢包括:

- 192GB HBM3E記憶體容量,遠超過Nvidia H100的80GB

- 5.3 TB/s記憶體頻寬,高於H100的3.3-3.9 TB/s

效能提升

- 訓練效率比Llama 2提升了約3倍

- 整體訓練時間利用率達到95%以上

- 在推理性能方面:

- 比Text Generation Inference(TGI)快1.5倍的吞吐量

- 首個token生成速度(TTFT)快1.7倍

系統優化

- Meta開發了先進的訓練系統,包括:

- 自動錯誤檢測與處理

- 改進的硬體可靠性

- 新的可擴展存儲系統

- 結合了三種並行化方式:

- 數據並行

- 模型並行

- 管道並行

Google 使用 AMD GPU 進行 LLM 的具體成果為何

Google Cloud主要是提供Nvidia的GPU產品,包括:

- H200

- H100

- L4

- T4

- A100等系列

目前沒有公開資料顯示Google在其雲端平台或內部AI開發中大規模採用AMD的GPU解決方案。

微軟使用 AMD Instinct MI300X GPU 如何增強其人工智能訓練

部署規模與配置

- Microsoft是首家在雲端平台部署AMD MI300X的供應商

- Azure ND MI300X v5系列虛擬機提供1.5TB的高頻寬記憶體(HBM)容量

- 用於支援最具挑戰性的AI訓練和生成式推理工作負載

效能表現

- 支援Azure OpenAI的ChatGPT 3.5和4服務

- 在Hugging Face平台上:

- 無需程式碼修改即可運行數十萬個AI模型

- 透過ROCm開源軟體生態系統實現

成本效益

- MI300X提供比Nvidia H100更具競爭力的價格

- 可作為解決Nvidia GPU供應短缺的替代方案

- Nvidia部分晶片交期長達一年

市場影響

- Microsoft支持多家晶片供應商以滿足客戶需求

- 分析師預測AMD將在未來1-2年內獲得顯著市場份額,類似其在伺服器市場對抗Intel的成功

技術優勢

- 192GB HBM3記憶體容量

- 5.3 TB/s記憶體頻寬

- 支援PCIe 5.0,有利於多GPU配置

FAQ

1. 什麼是 AMD ROCm,如何挑戰 NVIDIA CUDA?

AMD ROCm 是 AMD 提供的一個開源軟體生態系統,主要用於深度學習和人工智慧應用。透過支援主流框架(如 PyTorch 和 TensorFlow)以及提供像 FP8 格式、Flash Attention 3 和 Kernel Fusion 等新功能,ROCm 試圖挑戰 NVIDIA CUDA 的市場主導地位。

2. AMD GPU 在大規模 AI 訓練和推理工作負載上的表現如何?

AMD MI300X GPU 在大規模 AI 訓練和推理工作負載上具有高效能,使用 192GB HBM3E 記憶體與 5.3 TB/s 記憶體頻寬。它表現出比 NVIDIA H100 卓越 30% 的效能提升,並在推理任務中每百萬 tokens 成本更低。

3. ROCm 的開發者生態系統有哪些劣勢?

- 文檔品質相對 CUDA 較差,不完整且存在錯誤。

- 缺乏完整的開發者工具和生態系統支援。

- 社群規模較小,只有約 800 個 GitHub 追蹤者,相較 NVIDIA CUDA 擁有超過 6,700 人的追蹤。

- 某些軟體和硬體兼容性問題仍需解決。

4. Google 和 Meta 如何使用 AMD GPU 推進其 LLM 發展?

Google 部分採用了 AMD GPU 以進行大規模 AI 和 LLM 開發,適配增強多 GPU 執行效能;Meta 將 AMD MI300X 廣泛用於超大規模 Llama 模型的訓練,其效能比 Llama 2 提升約 3 倍,並顯示出優秀的 AI 訓練和推理效率。

5. 使用 AMD GPU 是否比 NVIDIA 更具成本效益?

是的,AMD MI300X 的售價遠低於 NVIDIA H100(MI300X 為 $10,000-15,000,而 H100 高達 $30,000-40,000)。此外,其每百萬 tokens 的推理成本也顯著降低,適合長期部署和成本敏感的企業需求,儘管 NVIDIA 具有更高的二手市場價值。