不想受限於雲端?這 10 款邊緣 AI LLM 解決方案,讓您輕鬆實現本地 AI 部署。

邊緣運算和本地 AI 已經有了顯著的發展,目前有許多強大的工具可以讓您在本地運行 LLM(大型語言模型)。以下是十大本地 LLM 解決方案:

流行的本地 LLM 解決方案

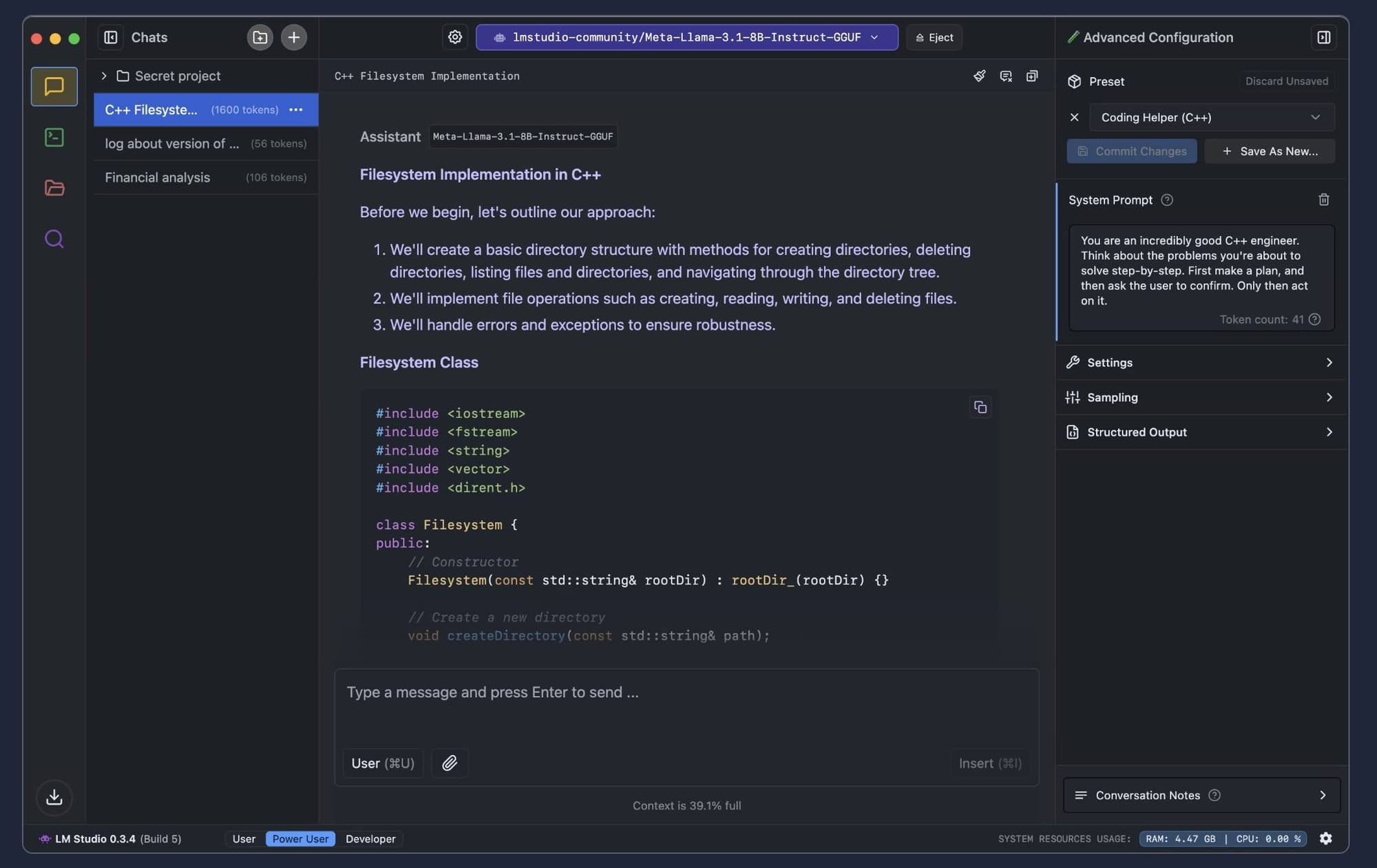

LM Studio

一款綜合性圖形界面工具,通過直觀的介面和集成的模型瀏覽器簡化了模型實驗。它支持跨平台部署,並提供 OpenAI 兼容的本地伺服器。

Ollama

一個簡化的解決方案,提供預先包裝的 LLM,安裝要求 minimal。支持多種模型,如 Llama2、Mistral 和 Dolphin,並具有出色的 GPU 優化和 LangChain 集成。

Faraday.dev

一個多功能平台,專為先進的 AI 模型訓練和部署而設,提供廣泛的自定義選項並支持尖端設置。

Local.ai

一個通用平台,具有廣泛的兼容性和強大的社群支持,適用於各種 LLM 任務。

OobaBogga

一個基於 Web 的介面,允許用戶從任何瀏覽器訪問模型,非常適合教育和實驗用途。

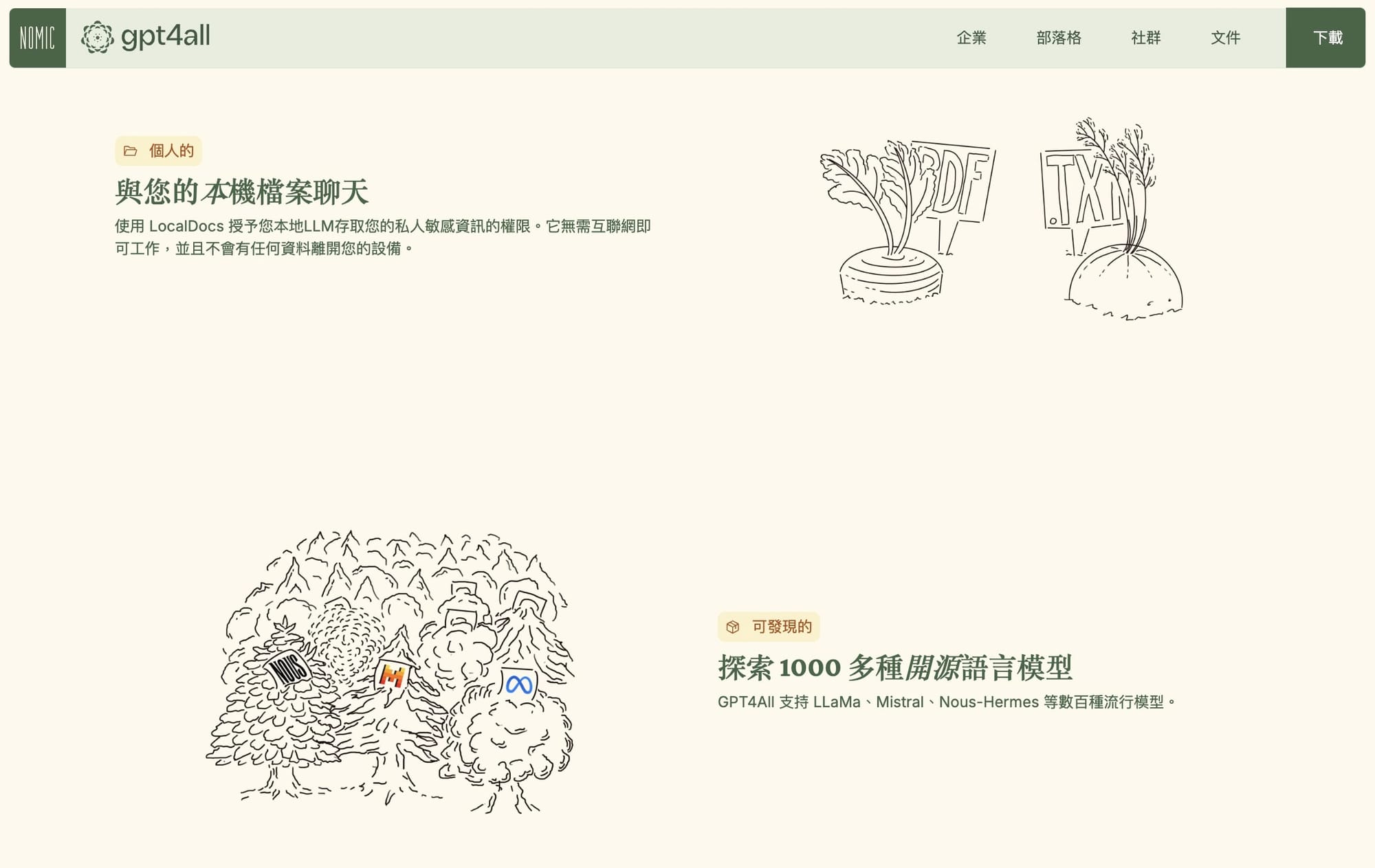

GPT4All

一款專門為在標準硬件上本地運行 GPT 模型而設的工具,尤其在 CPU 上表現高效。

Text Generation WebUI

一個基於瀏覽器的介面,支持多種模型,提供高自定義選項和多種模型加載器。

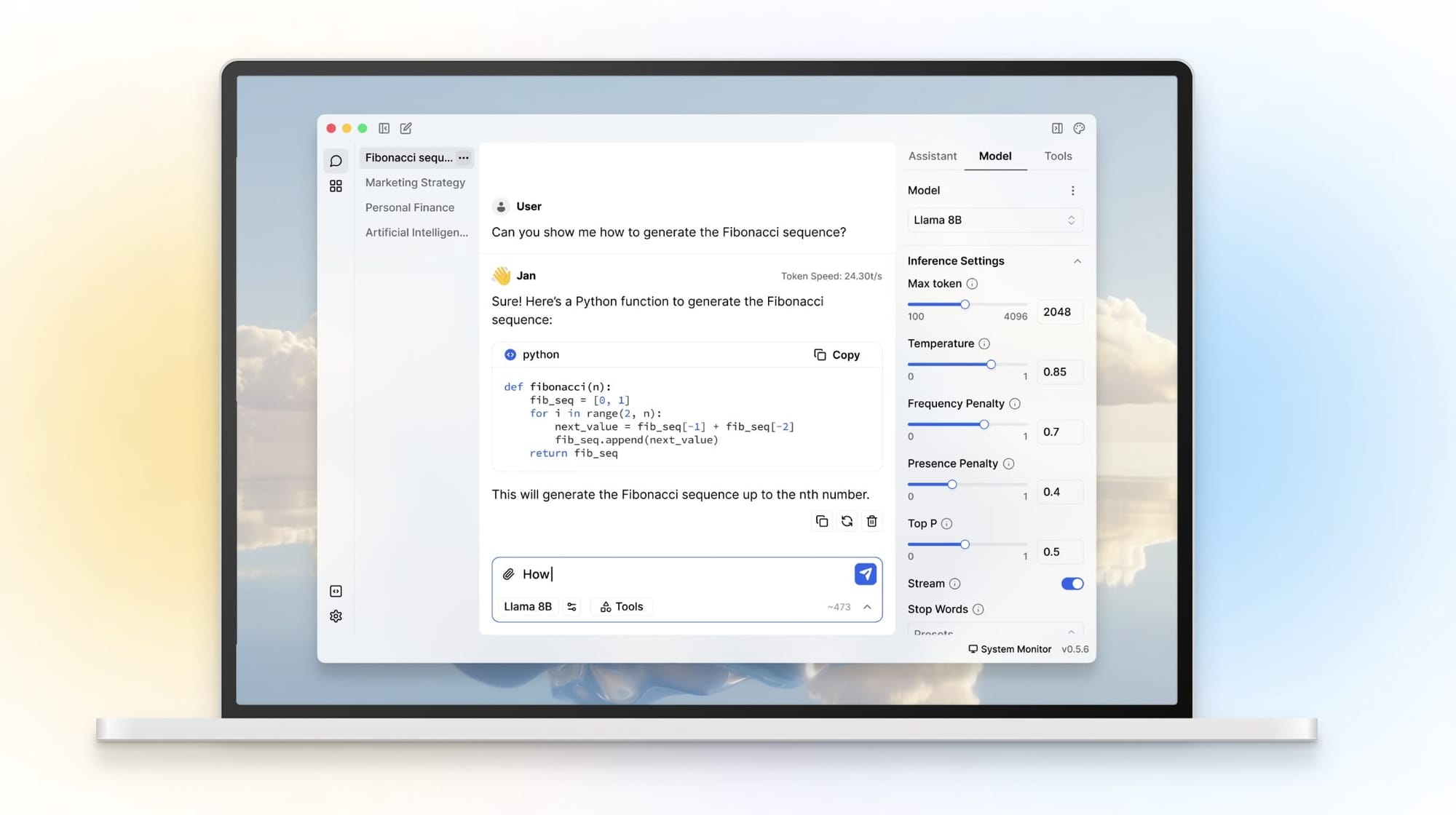

Jan

一款輕量級、隱私為重的開源 LLM,安裝簡單,並優先考慮高效的本地執行。

Chat with RTX

Nvidia 推出的 一個基於 RTX GPU 的 AI 對話工具,優化於 NVIDIA RTX GPU,提供快速的對話 AI 性能。

Transformers

Hugging Face 的綜合庫,支持各種模型,提供廣泛的自定義選項和出色的文檔。

性能考量

對於邊緣運算,建議使用小型語言模型(SLM),其參數數量低於 50 億,以達到最佳性能。以下是一些值得注意的例子:

- Llama 3.2 1B:1.24B 參數,優化於多語言對話

- Gemma 2 2B:2.6B 參數,訓練時使用了 2 萬億個 tokens

- Microsoft Phi:針對邊緣應用的高效模型

對初學者來說,哪個工具最適合在本地運行 LLM?

對於初學者來說,LM Studio 是最適合的選擇。原因如下:

用戶友好特性

直觀的介面

LM Studio 提供綜合性的圖形用戶界面,使得管理和互動 AI 模型變得簡單,不需要了解命令行操作。

硬體兼容性檢查

該軟件會自動檢查您的計算機規格,並僅顯示與您的硬體兼容的模型,避免安裝不兼容模型的困擾。

初學者友好的功能

內建的模型瀏覽器

LM Studio 配備集成的模型瀏覽器,並支持來自 Hugging Face 的多種模型,讓您輕鬆發現並下載新的模型。

跨平台支持

該工具可在 Windows、Linux 和 macOS 上運行,無論您使用哪種操作系統,都可以輕鬆訪問。

對初學者的主要優勢

- 類似 OpenAI 的界面,對 ChatGPT 用戶來說熟悉且易用

- 內建聊天和遊樂場功能,方便實驗和測試

- 模型參數的簡單定制,界面上有提示,易於理解

- 可以保存聊天歷史,以便日後參考

雖然 Ollama 是另一個受歡迎的選擇,但其主要使用命令行介面,對初學者可能較為艱難。LM Studio 的視覺化介面和指導式方法使其成為剛開始使用本地 LLM 的人的最佳選擇。

Ollama 和 LM Studio 之間的主要區別是什麼?

以下是 Ollama 和 LM Studio 的主要區別:

介面和可用性

Ollama

- 以命令行為主的介面

- 簡單、精簡的操作方式

- 適合熟悉終端命令的開發者

LM Studio

- 圖形用戶界面,具有直觀控制

- 可視化的模型管理和聊天界面

- 更適合初學者和非技術用戶

平台支持

| 特徵 | Ollama | LM Studio |

|---|---|---|

| Windows | 僅預覽 | 完全支持 |

| Linux | 完全支持 | 測試支持 |

| MacOS | 完全支持 | 完全支持 |

技術能力

模型支持

- Ollama:支持 61+ 模型以及 GGUF 轉換模型

- LM Studio:支持 25+ 模型以及 GGUF 轉換模型

API 集成

- Ollama:需要專門的連接器才能完全發揮功能

- LM Studio:提供直接的 OpenAI 兼容 API 集成

資源管理

Ollama

- 輕量級實現

- 佔用較少的系統資源

- 集中於預訓練模型

LM Studio

- 資源需求較高

- 提供進階的資源管理工具

- 提供精細的性能監控

用例優化

Ollama

- 最適合快速原型開發

- 適合快速部署場景

- 支持命令行自動化

LM Studio

- 理想的模型實驗平台

- 可以進行不同模型的可視化比較

- 提供擴展的自定義選項

哪個平台對 GPU 加速的支持更好?

根據兩個平台的 GPU 加速能力,這裡提供詳細比較:

GPU 支援

Ollama

- 現在支持 NVIDIA 和 AMD 顯示卡

- 比 CPU-only 設置快 2 倍的模型推理速度

- 透過 Docker 容器化提供靈活的 GPU 使用

LM Studio

- 主要優化於 NVIDIA RTX GPU

- 提供大型模型的 GPU 卸載能力

- 需要至少 6GB 的 VRAM 才能達到最佳性能

性能特點

Ollama

- 直接 GPU 加速,無記憶體限制

- 神經網絡訓練的並行處理優化

- 支持 61+ 模型的 GPU 加速

LM Studio

- GPU 卸載允許在較低端 GPU 上運行大型模型

- 透過滑塊介面自定義 GPU 使用

- 可以通過部分 GPU 加速本地運行資料中心級別的模型

結論

Ollama 提供更好的 GPU 加速支持,因為它支持更多硬體(包括 NVIDIA 和 AMD 顯示卡),並提供更靈活的實現選項。雖然 LM Studio 提供高級的 GPU 卸載功能,但其優化主要集中於 NVIDIA RTX GPU,使其在硬體配置較為多樣的情況下不如 Ollama 靈活。