發現使用無頭瀏覽器自動提取數據的威力!在2024年揭示網頁爬取的頂級工具。Headless Browser 無頭瀏覽器爬取是從網頁頁面提取數據的最佳方法之一。傳統的爬取過程通常需要您在瀏覽器內運行代碼,這可能不方便,因為它需要在具有圖形界面的環境內運行。

在傳統方法中,瀏覽器需要時間和資源來呈現您試圖爬取的網頁,這會減慢整個過程。如果您的項目涉及基本的數據提取,那麼您可能可以使用簡單的方法來實現。這就是無頭瀏覽器網頁爬取的用武之地。

在本指南中,我們將討論無頭瀏覽器是什麼,它們的優勢以及可用的最佳選擇。

什麼是無頭瀏覽器爬取?

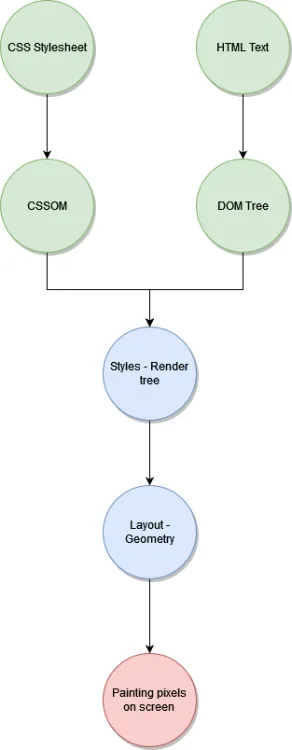

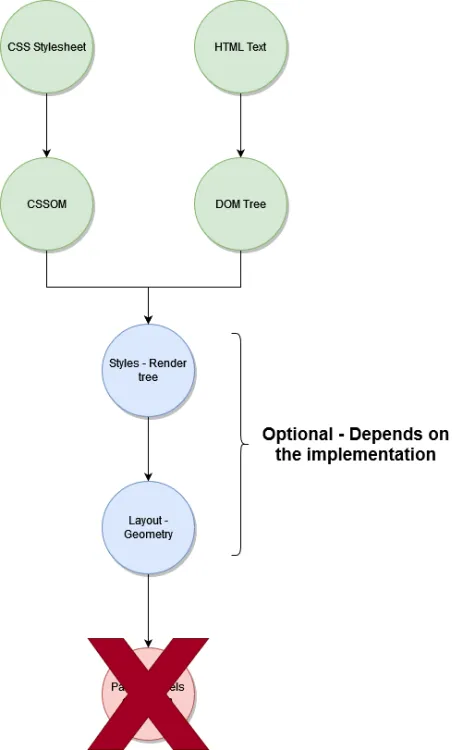

無頭瀏覽器爬取是指使用無頭瀏覽器進行網頁爬取的實踐,這本質上意味著在沒有圖形用戶界面的情況下爬取網頁。為了說明區別,考慮使用常規網絡瀏覽器進行爬取的過程:

現在,將此與使用無頭瀏覽器進行爬取的簡化過程進行比較:

儘管根據所使用的無頭瀏覽器不同,具體結果可能有所不同,但這就是無頭瀏覽的核心。

為此,您可以使用各種編程語言,包括Node.js、PHP、Java、Ruby、Python等等。這些語言的唯一要求是至少需要一個允許您與無頭瀏覽器進行交互的庫或套件。

無頭爬取更快嗎?

絕對是!無頭爬取速度更快,因為它涉及的步驟更少,以獲取所需的信息。

使用無頭瀏覽器,您跳過了整個用戶界面呈現過程。

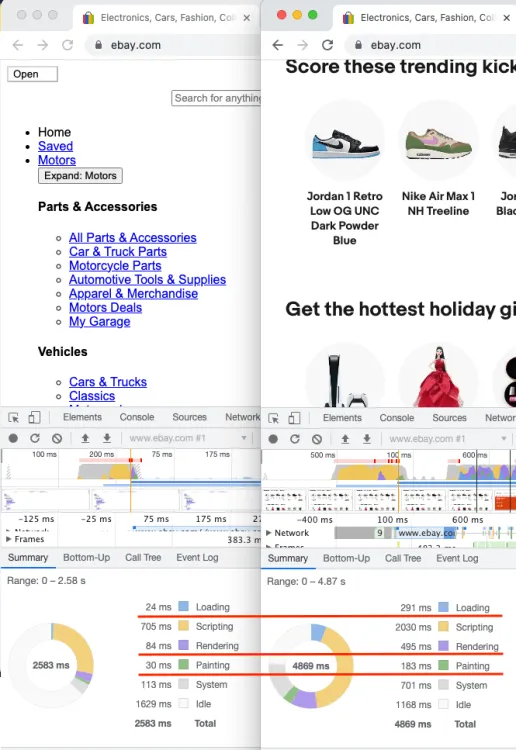

為了展示性能提升,讓我們使用Puppeteer,這是一個基於Chromium瀏覽器的自動化工具,來比較配置為避免加載圖片和CSS樣式的頁面加載結果,與常規頁面加載(例如eBay這種依賴圖片的網站)的結果:

正如您所看到的,當我們在不加載圖片和CSS樣式的情況下加載頁面時,我們節省了兩秒的時間。此外,呈現頁面所花的時間也大幅減少,因為儘管仍然需要一些呈現,但複雜度大大降低。

考慮一個現實情景:假設您有100個客戶,每天每個客戶都會進行100次爬取請求。通過在平均情況下為10,000個請求節省兩秒,您將節省近六小時的時間,而無需渲染所有這些資源。

這對您來說是否足夠顯著?

無頭瀏覽器可以被檢測到嗎?

僅僅因為您可以使用最新技術來爬取網站並不意味著您應該這樣做。網頁爬取有時可能被視為不當行為,某些網站開發人員會盡一切努力來阻止和阻撓爬取活動。

以下是一些檢測無頭瀏覽器爬取活動的技巧:

1. 請求頻率

請求頻率是一個明顯的指標。這與之前提到的性能的雙刃劍性質

一方面,同時發送更多的請求是有利的。然而,一個不希望被爬取的網站很快就會注意到,一個IP地址每秒發送太多的請求,並可能封鎖此類活動。為了避免檢測,如果您正在編寫自己的爬取器,您可以嘗試限制每秒發送的請求數,尤其是如果它們來自相同的IP地址。這種方法有助於模擬真實用戶的行為。

您可以發送的請求數每秒的精確限制取決於網站的限制,您可能需要通過試驗和錯誤來確定。

2. IP過濾

另一種區分真實用戶和試圖爬取網站的機器人的常見方法是通過已更新的IP地址黑名單。這些IP地址被認為不可信,因為它們過去曾發現爬取活動。

3. CAPTCHA

開發人員使用CAPTCHA來篩選機器人。這些CAPTCHA提供了一個簡單的問題,人類可以輕鬆解答,但對於自動化解決方案來說需要更多的工作。儘管計算機也可以解決CAPTCHA,但這是一個可能耗時的挑戰。

4. User-Agent檢測

所有瀏覽器都發送一個特殊的標頭,稱為“User-Agent”,其中包含識別瀏覽器及其版本的信息。希望防止爬取的網站通常會檢查此標頭以驗證其準確性。

例如,標準的Google Chrome瀏覽器發送以下User-Agent:Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/107.0.0.0 Safari/537.36。

相比之下,典型的無頭Chrome User-Agent如下所示:Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) HeadlessChrome/76.0.3803.0 Safari/537.36。顯然,它指示使用了Headless Chrome,立即顯示出非人類活動。

儘管可以操縱此標頭,但必須確保其準確性,以避免被執行User-Agent檢查的網站檢測到。

5. 瀏覽器指紋識別

瀏覽器指紋識別是一種技術,涉及收集系統的不同特徵並從中創建唯一標識符。

有多種實現此目標的方法,但如果執行得當,它們可以識別您和您的瀏覽器,即使您試圖隱藏您的身份。一種常見的技術是畫布指紋識別,它通過測量特定設置(例如顯示卡和瀏覽器版本)引起的明顯扭曲來實現。

即使您試圖掩蓋您的身份,系統中安裝的媒體設備列表也可以在後續會話中洩露您的身份。一些方法甚至使用聲音分析來進行指紋識別,就像可以使用Web音頻API來測量由振盪器生成的聲音波中的特定扭曲一樣。

避免被使用這些技術的網站檢測並不簡單。如果您的爬取活動不需要這些措施,您可以通過避免在其站點上執行JavaScript代碼來規避它們。

如果您遇到持久性問題,您有兩個選擇:繼續通過研究和試驗來完善您的方法,或考慮投資於付費爬取服務。

畢竟,如果您嘗試爬取一個有嚴格限制的網站,那麼您可能有一個重要的目的。在這種情況下,考慮分配一些預算,並委託專業人員處理這些挑戰。

無頭網頁爬取的好處是什麼?

無頭網頁爬取有幾個優點,包括:

1. 自動化: 無頭瀏覽器使爬取過程中的任務自動化成為可能,尤其是在處理結構不常變更的網站時,節省了大量時間和精力。

2. 提升速度: 無頭網頁爬取因為每個網站消耗的資源較少,加載時間縮短,所以速度顯著提高,節省了大量時間。

3. 結構化數據提取: 儘管網站內容看似無結構,但網站具有底層架構,可以利用這個架構提取所需信息。這些數據可以保存在像JSON或YAML這樣的機器可讀格式中,以便進一步處理。

4. 可能的帶寬節省: 無頭瀏覽可以優化,跳過從網頁下載大型資源,這不僅提高了性能,還減少了數據傳輸成本,特別是當使用基於數據傳輸量收費的代理或雲服務時。

5. 爬取動態內容: 無頭瀏覽器提供從動態頁面或單頁應用(SPA)提取數據的能力。這使得可以等待特定內容加載並與頁面互動,包括導航和表單提交。

總結

總之,網絡爬取是從各種在線來源收集數據並將其匯總為各種目的的有價值工具。它代表了一種成本效益高的數據提取方法,使您能夠高效地自動化任務。

無頭網絡爬取更進一步,提供了更快速、更經濟的方法。在本指南中,您已經了解到無頭瀏覽器網絡爬取的基礎知識,包括其類型、優點、缺點和可用工具。

簡要回顧一下,一些值得注意的無頭瀏覽器包括:

- ZenRows

- Puppeteer

- Selenium

- HTMLUnit

請記住,選擇“最佳”無頭瀏覽器取決於您的爬取項目的具體要求。當您深入網絡爬取的世界時,請考慮這些因素,並選擇最適合您需求的工具。

無頭瀏覽器網路抓取工具:GitHub

想要高效提取網路數據,卻被傳統爬蟲工具搞得頭昏眼花?快來尋寶吧!這篇指南帶你探索 GitHub 上最優秀的無頭瀏覽器網路刮取工具,助你輕鬆實現自動化數據獲取! 點擊即可查看工具簡介、功能特色,還有 GitHub 連結直接帶你開挖寶藏!無論你是數據分析師、研究人員還是 SEO 專家,都能在這篇文章找到適合你的神器!

| Rank | Title | Description | GitHub Stars | URL |

|---|---|---|---|---|

| 1 | Scrapy | Robust and scalable web scraping framework in Python, capable of handling complex tasks with headless browser integration. | 58.5k | https://scrapy.org/: https://scrapy.org/ |

| 2 | Playwright | Powerful cross-browser automation library for Node.js and Python, ideal for web scraping with headless Chrome and Firefox. | 23.9k | https://github.com/microsoft/playwright: https://github.com/microsoft/playwright |

| 3 | Puppeteer | Popular library for controlling headless Chrome in Node.js, allowing for web scraping, automation, and screenshotting. | 32.2k | https://github.com/puppeteer/puppeteer: https://github.com/puppeteer/puppeteer |

| 4 | Selenium | Widely used framework for browser automation in various languages, including headless browsing for web scraping. | 28.7k | https://www.selenium.dev/: https://www.selenium.dev/ |

| 5 | Apify Crawlee | Node.js library for building reliable web crawlers, offering headless scraping capabilities and advanced features. | 10.9k | https://github.com/apify/crawlee: https://github.com/apify/crawlee |

| 6 | Autoscraper | Python library for automatically generating web scraping scripts based on page structure, simplifying development. | 5.7k | https://github.com/alirezamika/autoscraper: https://github.com/alirezamika/autoscraper |

| 7 | Scrapy-pyppeteer | Integration library for using Puppeteer within Scrapy projects, combining headless scraping power with Scrapy’s features. | 59 | https://github.com/lopuhin/scrapy-pyppeteer: https://github.com/lopuhin/scrapy-pyppeteer |

| 8 | tanakai | Modern web scraping framework in Ruby, built on Capybara and Nokogiri, with headless browser support. | 219 | https://github.com/glaucocustodio/tanakai: https://github.com/glaucocustodio/tanakai |

| 9 | scraper | Node.js based scraper using headless Chrome, offering basic scraping functionalities and an easy-to-use API. | 192 | https://github.com/JohnScooby/Google-Scraper: https://github.com/JohnScooby/Google-Scraper |

| 10 | abotx | Cross-platform C# web crawling framework, including headless browser capabilities and parallel scraping features. | 108 | https://github.com/sjdirect/abotx: https://github.com/sjdirect/abotx |